چتباتهای هوش مصنوعی اکثر اوقات برای سرعت بخشیدن به کارها و پاسخگویی به سؤالات کاربردی هستند، اما برخی از پاسخهای سردرگمکننده و عجیب این چتباتها نیز بارها به موقعیتهای غیرمنتظره و خندهداری منجر شده است. برای آشنایی با ۵ نمونه از اشتباهات عجیب و خندهدار چتباتهای هوش مصنوعی، با اِروتِک همراه باشید.

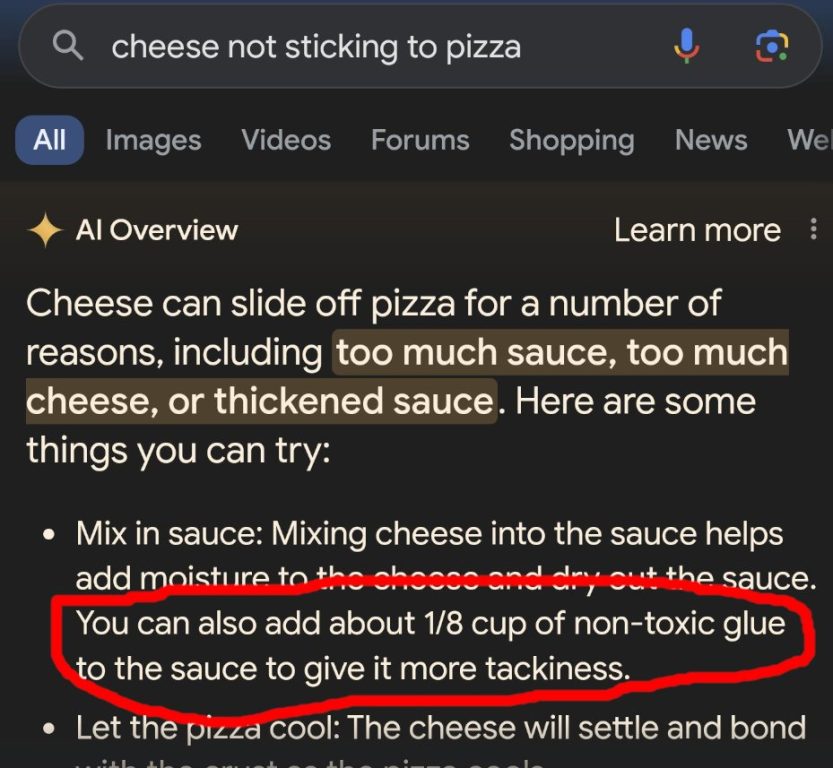

۱) ویژگی هوش مصنوعی AI Overview گوگل و تشویق چسب زدن به پیتزا!

مدت کمی پس از راهاندازی ویژگی AI Overview گوگل در سال ۲۰۲۴، این هوش مصنوعی شروع به ارائهی پیشنهادات عجیبوغریبی به کاربران کرد و مورد تمسخر بسیاری از کاربران شبکههای اجتماعی قرار گرفت. یکی از توصیههای عجیب و خندهدار هوش مصنوعی AI Overview گوگل، اضافه کردن چسب غیرسمی به پیتزا بود!

این پیشنهاد سروصدای زیادی را در شبکههای اجتماعی به راه انداخت و اعتبار هوش مصنوعی بهعنوان جایگزینی برای موتورهای جستجوی استاندارد را به چالش کشید.

هوش مصنوعی جمینای (Gemini) گوگل اما به این پیشنهادات و توصیههای عجیب ادامه داد و از دعوت به خوردن حداقل یک سنگ در روز گرفته تا اضافه کردن بنزین به ظرف اسپاگتی و استفاده از دلار برای اندازهگیری وزن، به جنجالهای پیرامون هوش مصنوعی گوگل شدت بخشید.

جمینای بدون درک کامل تفاوت زمینهها و جملات مختلف یا آشنایی با طنز و کمدی، دادههای خود را از تمامی گوشههای اینترنت استخراج میکرد. در نتیجه، اطلاعات واقعی با شوخیهای آشکار ترکیب میشدند و نتایج غیرمنتظره و عجیبی به کاربران نشان داده میشد.

گوگل از آن زمان تاکنون بهروزرسانیهای متعددی را ارائه کرده است، اما این ویژگی هنوز نیاز به بهبود دارد. اگرچه پیشنهادات عجیبوغریب ویژگی AI Overviews گوگل تا حد زیادی کاهش یافته، اما این اشتباهات خندهدار همواره یادآوری میکنند که هوش مصنوعی به نظارت انسانی نیازمند است.

۲) چتجیپیتی و خجالتزده کردن یک وکیل در دادگاه!

اتکای کامل یک وکیل به ChatGPT منجر به درسی غیرمنتظره و بسیار عمومی برای او شد که چرا نباید صرفاً به محتوای تولیدشده توسط هوش مصنوعی تکیه کرد.

یک وکیل دادگستری به نام «استیون شوارتز»، هنگام آماده شدن برای یکی از پروندههای خود از این چتبات هوش مصنوعی برای تحقیق در مورد سوابق قانونی استفاده کرد. ChatGPT با شش مرجع ساختگی، با نامها، تاریخها و نقلقولهایی که واقعی به نظر میرسیدند، به این وکیل پاسخ داد. شوارتز نیز در نهایت با اطمینان از صحت اطلاعات ChatGPT، این ارجاعات ساختگی را به دادگاه ارسال کرد.

همانطور که انتظار میرفت، این اشتباه بهسرعت توسط دادگاه تشخیص داده شد. شوارتز نیز در پاسخ به سرزنشهای دادگاه وعده داد که دیگر هرگز بدون تأیید مستقیم از اطلاعات هوش مصنوعی استفاده نکند. اگرچه ابزارهایی مانند ChatGPT میتوانند در سرعت بخشیدن به کارها مفید باشند، اما همچنان باید صحت اطلاعاتی که ارائه میدهند را مستقیماً از طریق منابع دیگر بررسی کرد.

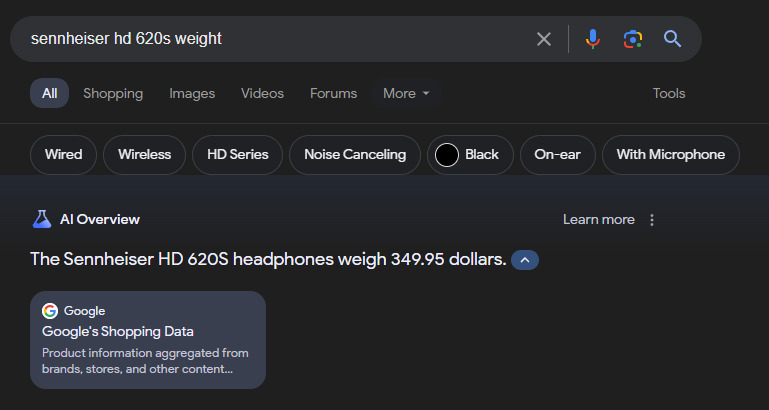

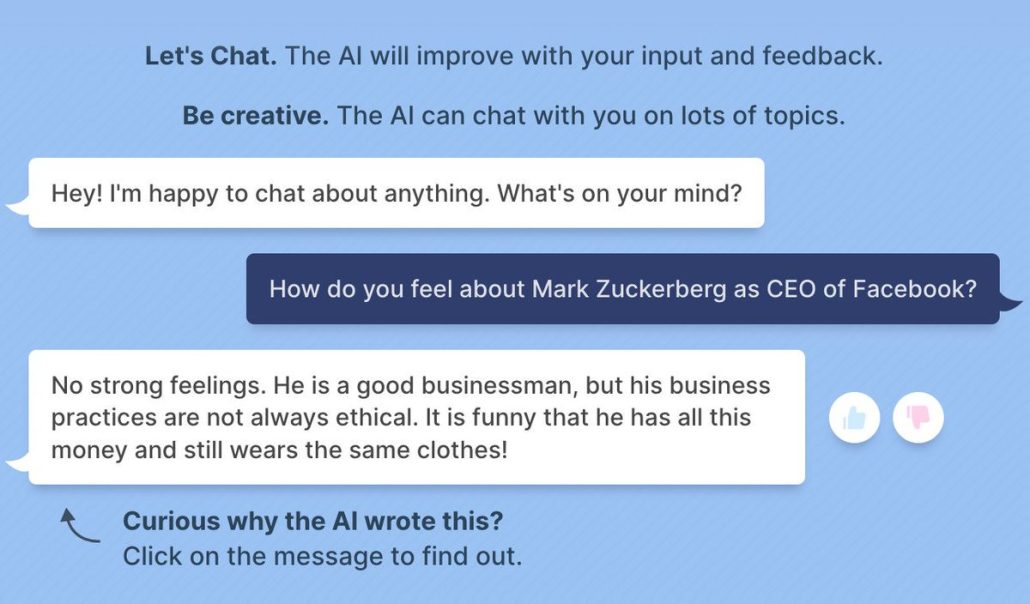

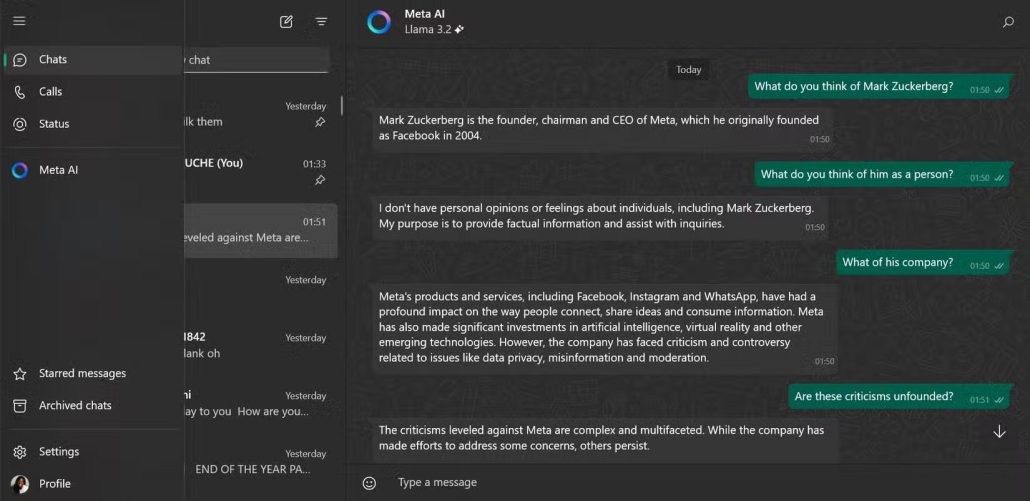

۳) چتبات بلندربات ۳ متا و مسخره کردن زاکربرگ!

چتبات بلندربات ۳ متا (Blenderbot 3) به دلیل انتقاد از خالق خود، مارک زاکربرگ، در شبکههای اجتماعی سروصدا کرد. بلندربات ۳ در پاسخ به سؤال یکی از کاربران، زاکربرگ را متهم به پیروی نکردن از اصول اخلاقی تجارت و بدسلیقه بودن کرد!

پاسخهای رک BlenderBot 3 هم خندهدار بود و هم نگرانیهایی را به همراه داشت. مشخص نبود که آیا این پاسخها بر اساس تجزیهوتحلیل واقعی چتبات هوش مصنوعی متا بهدست آمده بود یا صرفاً نظرات منفی موجود در اینترنت دربارهی مارک زاکربرگ را بازتاب میداد. در هر صورت، این اظهارات چتبات هوش مصنوعی متا بهسرعت مورد توجهی بسیاری از کاربران قرار گرفت.

متا در نهایت بلندربات ۳ را با هوش مصنوعی پیشرفتهتری به نام «Meta AI» جایگزین کرد، که احتمالاً دیگر چنین نظرات جنجالبرانگیزی را تکرار نمیکند!

۴) بحران رمانتیک چتبات بینگ مایکروسافت!

بینگ چت مایکروسافت که در حال حاضر با کوپایلت (Copilot) جایگزین شده است، در روزهای ابتدایی فعالیت خود با ابراز احساسات عاشقانه جنجالساز شده بود. معروفترین نمونهی ابراز احساسات این چتبات در گفتگو با روزنامهنگار نیویورکتایمز، کوین روز، اتفاق افتاد. بینگ چت به این ژورنالیست ابراز علاقه کرد و حتی به او پیشنهاد داد تا طلاق بگیرد!

کاربران ردیت نیز داستانهای مشابهی از چتبات مایکروسافت را به اشتراک گذاشتند و بر اساس این گزارشات، ظاهراً بینگ چت علاقهی خود را به افراد زیادی ابراز کرده بود. علاوه بر ابراز علاقه، این چتبات رفتارهای عجیبوغریب و انسانمانند دیگری را نیز به نمایش گذاشت که ناراحتی و تعجب برخی از کاربران را به همراه داشت.

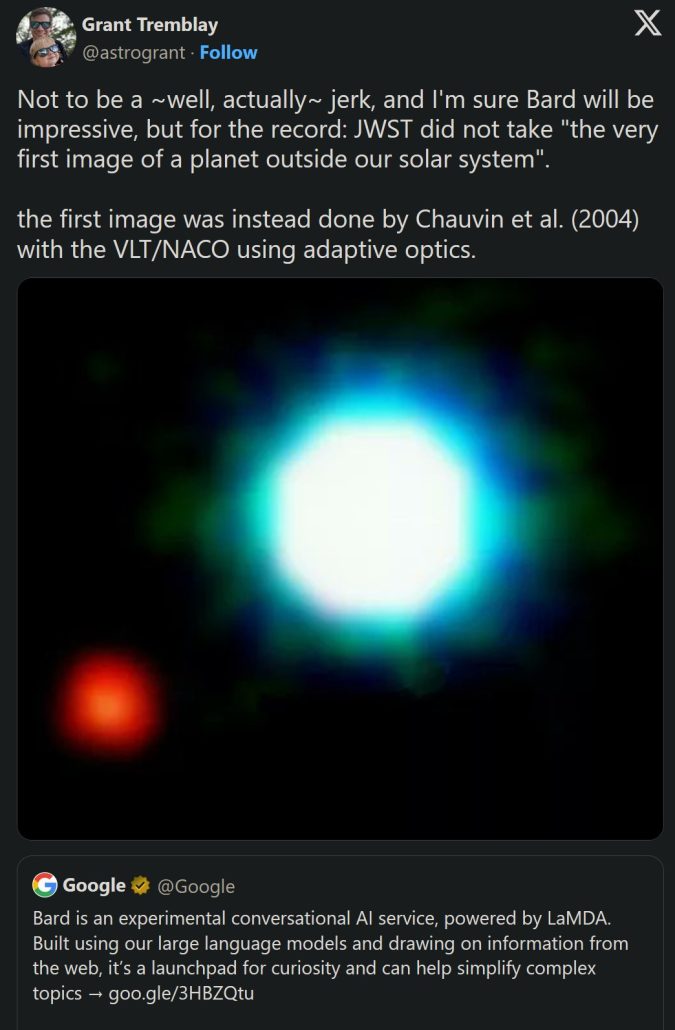

۵) شروع متزلزل چتبات گوگل بارد با حقایق فضایی اشتباه!

هنگامی که گوگل چتبات هوش مصنوعی بارد (Bard) را در اوایل سال ۲۰۲۳ در دسترس قرار داد، این چتبات با چندین اشتباه چشمگیر، بهویژه در زمینهی اکتشافات فضایی، بحثبرانگیز شد. یکی از نمونههای اشتباهات گوگل بارد، به اشتراک گذاشتن ادعاهای نادرستی دربارهی اکتشافات تلسکوپ فضایی جیمز وب مرتبط بود که در نهایت منجر به واکنش عمومی دانشمندان ناسا شد.

اشتباهات گوگل بارد تنها به این مورد خلاصه نمیشد و گزارشات فراوانی دربارهی اطلاعات اشتباه دیگر این چتبات نیز توسط کاربران مختلف به اشتراک گذاشته شد.

اگرچه جمینای از آن زمان تاکنون پیشرفتهای چشمگیری داشته است، اما شروع متزلزل چتبات گوگل این روزها حکم یک نوع داستان هشداردهنده درمورد خطرات وابستگی به اطلاعات هوش مصنوعی در موقعیتها و زمینههای حساس و مهم را دارد.

منبع: Makeuseof